Classificació probabilística

En l'aprenentatge automàtic, un classificador probabilístic és un classificador que és capaç de predir, donada una observació d'una entrada, una distribució de probabilitat sobre un conjunt de classes, en lloc de donar només la classe més probable a la qual hauria de pertànyer l'observació. Els classificadors probabilistes proporcionen una classificació que pot ser útil per si mateixa [1] o quan es combinen classificadors en conjunts.[2]

Tipus de classificació[modifica]

Formalment, un classificador "ordinari" és una regla o funció que assigna a una mostra x una etiqueta de classe ŷ :

Les mostres provenen d'algun conjunt X (per exemple, el conjunt de tots els documents, o el conjunt de totes les imatges ), mentre que les etiquetes de classe formen un conjunt finit Y definit abans de l'entrenament.

Els classificadors probabilistes generalitzen aquesta noció de classificadors: en comptes de funcions, són distribucions condicionals , és a dir, per a un determinat , assignen probabilitats a tots (i aquestes probabilitats sumen una). La classificació "difícil" es pot fer mitjançant la regla de decisió òptima [3] :39–40

o, en anglès, la classe prevista és la que té més probabilitat.

Els classificadors probabilistes binaris també s'anomenen models de regressió binaris en estadística. En econometria, la classificació probabilística en general s'anomena elecció discreta.

Alguns models de classificació, com ara Bayes ingenu, regressió logística i perceptrons multicapa (quan s'entrenen sota una funció de pèrdua adequada) són naturalment probabilistes. Altres models com les màquines de vectors de suport no ho són, però existeixen mètodes per convertir-los en classificadors probabilistes.[4]

Calibració de probabilitats[modifica]

No tots els models de classificació són naturalment probabilistes, i alguns que són, sobretot classificadors Bayes ingenus, arbres de decisió i mètodes d'impuls, produeixen distribucions de probabilitat de classe distorsionades. En el cas dels arbres de decisió, on Pr(y|x) és la proporció de mostres d'entrenament amb l'etiqueta y a la fulla on acaba x, aquestes distorsions es produeixen perquè els algorismes d'aprenentatge com C4.5 o CART tenen com a objectiu explícitament produir homogenis. fulles (donant probabilitats properes a zero o un, i per tant un biaix elevat) mentre s'utilitzen poques mostres per estimar la proporció rellevant ( variància alta).

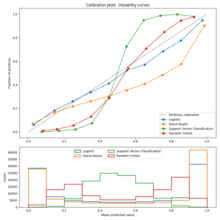

El calibratge es pot avaluar mitjançant un diagrama de calibratge (també anomenat diagrama de fiabilitat).[5] Un gràfic de calibratge mostra la proporció d'ítems de cada classe per a bandes de probabilitat o puntuació prevista (com ara una distribució de probabilitat distorsionada o la "distància amb signe a l'hiperpla" en una màquina vectorial de suport). Les desviacions de la funció d'identitat indiquen un classificador mal calibrat per al qual les probabilitats o puntuacions previstes no es poden utilitzar com a probabilitats. En aquest cas, es pot utilitzar un mètode per convertir aquestes puntuacions en probabilitats de pertinença a classe correctament calibrades.

Referències[modifica]

- ↑ Hastie, Trevor. The Elements of Statistical Learning (en anglès), 2009, p. 348.

- ↑ «A Review on Automatic News Classification using the Probabilistic Classification Algorithms». International Journal of Science and Research (IJSR), 5, 6, 05-06-2016, pàg. 1391–1395. DOI: 10.21275/v5i6.nov164530. ISSN: 2319-7064.

- ↑ Bishop, Christopher M. Pattern Recognition and Machine Learning (en anglès). Springer, 2006.

- ↑ «Probabilistic Models in Machine Learning» (en anglès americà), 09-05-2023. [Consulta: 12 maig 2024].

- ↑ «Probability calibration» (en anglès). jmetzen.github.io. [Consulta: 18 juny 2019].